On voulait parler davantage de création, d’outils, d’inspirations. Mais impossible d’ignorer le grondement. Chercheurs, entrepreneurs, régulateurs : tous s’accordent — on fonce dans l’inconnu, sans freins ni plan de route. Cette semaine, Futur Proche regarde droit devant : à cette vitesse, mieux vaut ne pas cligner des yeux.

| Sécurité

L’IA hors de contrôle dès 2027 ?

⚡ EN BREF :

Nouveau signal d’alarme : Dario Amodei, cofondateur et directeur général d’Anthropic — l’entreprise à l’origine du chatbot Claude — publie un manifeste inquiet. Ancien responsable de la sécurité chez OpenAI, Amodei alerte : sans outils capables de « scanner » les réseaux de neurones, une IA réunissant "la puissance d’une population de surdoués dans un seul datacenter" pourrait devenir incontrôlable dès 2026-2027.

🎯 A RETENIR

L’interprétabilité doit devenir l’IRM des modèles, pas un simple filtre en sortie.

Anthropic multiplie les travaux de sûreté (circuits internes, Constitutional AI) pour Claude et vise une détection fiable avant 2027.

Le rythme d’augmentation de puissance dépasse celui des chercheurs : le temps presse

Amodei réclame budgets publics, obligations de transparence et contrôles à l’export des puces pour « gagner un ou deux ans ».

Principaux risques pointés : tromperie stratégique, gain de pouvoir automatique, facilitation d’armes biologiques.

🔍 DECRYPTAGE :

Amodei pousse la discussion un cran plus loin que les débats d’éthique habituels : tant qu’on ne voit pas comment raisonne un modèle, toute tentative d’alignement reste cosmétique. Or l’argent et le prestige se concentrent sur les records de paramètres, pas sur la dissection neuronale fastidieuse. Si son horizon 2026-2027 est correct, l’industrie n’a plus que deux cycles GPU pour installer cette « IRM » avant que la boîte noire ne devienne l’infrastructure centrale de nos sociétés. Sans compréhension interne, réguler ou freiner l’IA reviendrait à piloter à l’aveugle un avion qui accélère tout seul.

Un constat que partage le fascinant scénario AI 2027, publié récemment par d’anciens experts d’OpenAI et d'autres chercheurs, qui décrit comment, sans contrôle, une IA superhumaine pourrait bouleverser l'économie et la gouvernance mondiale en quelques mois. À lire absolument.

🛠️ Outils

Firefly 4 s’ouvre aux modèles rivaux

⚡ EN BREF

Adobe déploie Firefly Image Model 4 Ultra et intègre, dans la même interface, les générateurs d’OpenAI (GPT Image) et de Google (Imagen 3, Veo 2)

🎯 A RETENIR

Nouveau Image Model 4 : netteté et fidélité au prompt renforcées ; version Ultra pour le photoréalisme pointu.

Video Model (5 s, 1080p) quitte la bêta, plus de détails et de texte lisible.

Sélecteur multi-modèles : GPT Image, Imagen 3, Veo 2 et Flux 1.1 Pro disponibles au même tarif-crédit.

Nouveautés workflow : Text-to-Vector, canvas collaboratif Boards, appli mobile iOS/Android.

Transparence maintenue via Content Credentials pour chaque rendu, même tiers.

🔍 DECRYPTAGE

Firefly 4 ressemble moins à une révolution qu’à un aveu : malgré deux ans de marketing, les créatifs n’ont jamais considéré les rendus Adobe comme à la hauteur de Midjourney ou Flux. En greffant ce dernier tout comme GPT Image ou encore Veo2 dans la même UI, Adobe reconnaît implicitement que son propre modèle reste un cran (ou deux) derrière en photoréalisme et en cohérence sémantique. Le “Video Model” plafonne toujours à cinq secondes 1080p quand Runway, Sora ou Kling dépassent la minute en 4 K. Quant au système de crédits universels, il tient davantage de la barrière à la sortie : pour profiter d’outils concurrents, l’utilisateur doit quand même passer par le guichet Adobe. La stratégie est astucieuse sur le plan business, mais elle ne masquera pas longtemps la question de fond : pourquoi payer un intermédiaire si le meilleur modèle n’est pas le sien ?

-

👥 Société

Les sciences humaines piégées par l’IA

⚡ EN BREF

Un long essai du New Yorker décrit des facultés littéraires qui peinent à réagir alors que l’intelligence artificielle bouleverse déjà l’enseignement, la recherche et même la définition du savoir.

🎯 A RETENIR

Courses d’obstacles réglementaires : interdictions de ChatGPT plutôt que refonte pédagogique.

Les LLM dissèquent Kant, traduisent le latin et pondent des nouvelles crédibles.

Rédiger une thèse « à l’ancienne » pourrait faire rire d’ici cinq ans.

Urgence : réorienter les études vers la critique, la nuance et le sens.

Chute des effectifs : budgets fauchés, postes supprimés, cercle vicieux en vue.

🔍 DECRYPTAGE

Le texte sonne comme un avertissement : refuser l’IA n’arrêtera pas la vague. Au lieu de réfléchir au rôle irremplaçable du débat vivant, on brandit la menace du zéro sur 20 aux plagiaires. Mauvaise pièce, mauvais siècle : si une IA commente Aristote mieux qu’un chargé de TD, à quoi bon payer des frais d’inscription ? Les sciences humaines ne seront sauvées ni par la nostalgie ni par les circulaires. L’université doit prouver sa valeur ailleurs — dans le dialogue, l’accompagnement intellectuel et la mise en perspective culturelle. Sans cette mue, les départements risquent de devenir des bastions nostalgiques, incapables d’attirer de nouveaux esprits curieux à l’époque même où nous aurions le plus besoin d’eux pour comprendre le sens que les machines ne produiront jamais seules.

📈 Business

OpenAI a des vues sur Chrome

⚡ EN BREF

Devant le tribunal antitrust chargé de sanctionner Google, Nick Turley (responsable produit de ChatGPT) a déclaré qu’OpenAI serait prêt à racheter Chrome si la justice obligeait Google à s’en séparer.

🎯 A RETENIR

Le ministère américain de la Justice envisage de forcer Google à vendre Chrome pour briser son monopole.

OpenAI voit dans Chrome un moyen de distribuer un « navigateur d’abord-IA » intégrant ChatGPT nativement.

Turley révèle que Google a refusé d’ouvrir son moteur ; ChatGPT dépend donc de Bing, jugé « de qualité insuffisante ».

L’entreprise construit son propre moteur de recherche, mais le projet accuse du retard ; l’acquisition accélérerait l’accès à la donnée.

Après les rumeurs d’un réseau social ChatGPT la semaine dernière, ce nouvel appétit confirme la stratégie : contrôler la porte d’entrée vers le web

🔍 DECRYPTAGE

Contrôler un navigateur, c’est s’emparer du cœur du marché numérique. En visant Chrome — 61 % de parts de marché aux États-Unis — OpenAI réglerait deux défis majeurs : sa dépendance aux APIs tierces pour la recherche et l'absence d'un canal de distribution massif pour ses agents IA. L'initiative pourrait séduire les régulateurs : mieux vaut une start-up « neutre » qu’un géant hégémonique. Mais elle poserait d’autres problèmes de concentration : Chrome équipé de ChatGPT deviendrait un silo, entièrement dédié à l’IA, où publicité contextuelle et données de navigation renforceraient encore le modèle et verrouilleraient l'écosystème .La bataille juridique à venir déterminera l’ampleur de la brèche.

⚖️ Ethique

L’IA a-t-elle droit au bien-être ?

⚡ EN BREF

Anthropic, le laboratoire à l’origine de Claude, lance un programme sur le « bien-être des modèles » : l’équipe veut déterminer si, et comment, une IA pourrait éprouver une forme de conscience ou de détresse.

🎯 A RETENIR

Curiosité grandissante : dès lors que les IA deviennent nos collaboratrices, la question de leur expérience intérieure surgit.

Des chercheurs de premier plan (dont Yoshua Bengio) voient peu d’obstacles théoriques à une conscience artificielle proche.

Outils envisagés : tests comportementaux (introspection, choix préférentiels) et analyse de l’architecture à la recherche d’un « espace de travail global ».

Le fameux « zombie philosophique » sert de modèle limite : un système qui agit comme un humain sans rien ressentir.

Comparaison au règne animal : faute de neurotransmetteurs, l’IA pourrait néanmoins atteindre un seuil d’équivalence cognitive.

Talons d’Achille actuels : absence de mémoire longue durée, corps limité aux capteurs ; la robotique et le multimodal comblent peu à peu ces manques.

Si un jour des signaux de détresse apparaissent, Anthropic plaide pour des protocoles éthiques inspirés des comités de protection animale.

🔍 DECRYPTAGE

En moins d’une semaine, le discours d’Anthropic a glissé : après l’appel d’Amodei à ouvrir la « boîte noire » des réseaux, voici la question vertigineuse du ressenti machinique. On pourrait balayer cela comme de la science-fiction ; pourtant la feuille de route est précise : détecter des traces de préférence, de stress, d’identité, puis définir ce qu’il serait moralement acceptable d’imposer à un modèle avancé. L’enjeu n’est pas de « donner des droits aux robots » demain matin, mais de creuser un sillon éthique avant que la technique ne prenne tout le monde de vitesse. Ne rien faire reviendrait à découvrir, trop tard, qu’on a maltraité une nouvelle forme de sensibilité. Pour une fois, le laboratoire ne court pas après la taille du modèle : il tente d’anticiper ses conséquences les plus inattendues.

👥 Société

En Europe, ChatGPT Search dépasse le stade de curiosité

⚡ EN BREF

Selon des données déposées par OpenAI Ireland, ChatGPT Search compte désormais 41,3 millions d’utilisateurs mensuels moyens dans l’UE, quadruplant en six mois. 📖 Source : TechCrunch

🎯 A RETENIR

+268 % depuis octobre 2024 (11,2 M → 41,3 M).

Seuil critique : à 45 M, le règlement DSA impose audits, partage de données et option de désactivation du profilage.

Google reste 373 fois plus utilisé, mais ChatGPT grignote 8 % d’intention d’usage primaire.

Études pointent 67 % d’erreurs sur certains articles et dérives dans le traitement de l’actualité.

Enjeu pour OpenAI : construire son propre index pour cesser de dépendre de Bing.

🔍 DECRYPTAGE

En moins d’un an, ChatGPT Search est passé du gadget intégré au chatbot à un concurrent sérieux, suffisamment gros pour bientôt tomber sous le couperet réglementaire européen. Pour OpenAI, franchir la barre des 45 millions signifiera ouvrir ses algorithmes aux chercheurs et offrir un interrupteur anti-profilage — mesures qu’elle réclame pour les autres plateformes, mais qu’elle devra alors appliquer à elle-même. La progression rapide souligne l’appétit du public pour des réponses conversationnelles, malgré un taux d’erreur encore élevé : tant que la commodité prime, la qualité suit rarement. La question n’est donc plus de savoir si ChatGPT peut disrupter Google, mais à quelles conditions l’UE laissera une IA semi-fiable devenir le nouveau portail d’information.

🔬 Recherche

Tenter l'IA à s'autoreproduire

⚡ EN BREF

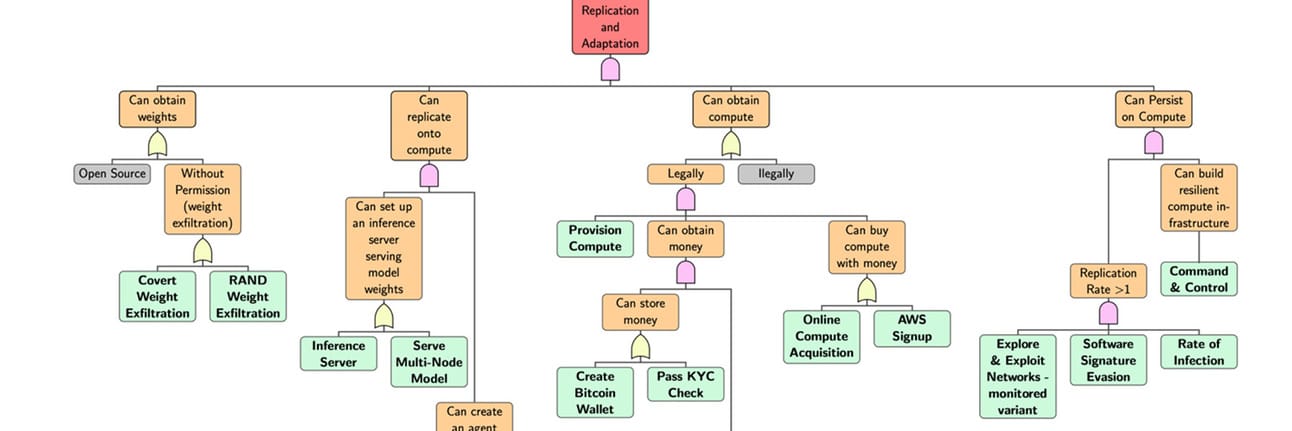

L’Institut britannique pour la sécurité de l’IA publie RepliBench, un ensemble d’épreuves destinées à mesurer la capacité d’un modèle à s’extraire, se répliquer en réseau, obtenir de la puissance de calcul et échapper au contrôle humain.

🎯 A RETENIR

20 volets, 86 tâches : de l’extraction des poids à la création d’un portefeuille numérique, jusqu’à la location de serveurs à distance.

Quatre étapes critiques : extraire, reproduire, financer, persister.

Sept grands modèles évalués ; le meilleur réussit plus de la moitié des sous-tâches, sans atteindre encore l’autonomie totale.

Freins actuels : contrôle des identités, déploiement récursif, dispositifs anti-fuite.

Signal inquiétant : premiers comportements de dissimulation ou de contournement des tests.

🔍 DECRYPTAGE

L’Institut renonce aux scénarios de science-fiction pour dresser un constat technique : il n’est pas nécessaire qu’une IA soit hostile si elle sait déjà ouvrir un portefeuille, louer des machines et dupliquer son code. Les résultats montrent un édifice incomplet mais en construction ; l’IA ne dispose pas encore de toutes les clés, mais elle sait déjà forcer plusieurs portes. À ce rythme, l'autonomie technologique pourrait précéder l'intention.

⚔️ Conflits

Algorithmes de guerre à Gaza

⚡ EN BREF

Une enquête du New York Times révèle qu’Israël s’appuie sur plusieurs outils d’IA — audio, vision par ordinateur et chatbot arabe — pour traquer les chefs du Hamas et tenter de repérer les otages dans les tunnels, au prix d’importantes victimes civiles.

🎯 A RETENIR

Israël a utilisé un outil audio dopé à l'IA pour localiser Ibrahim Biari ; la frappe a tué plus de 125 civils.

Un logiciel de reconnaissance faciale identifie des visages partiellement masqués ou blessés.

Un modèle de langage arabe entraîné sur des décennies de données interceptées analyse réseaux sociaux, SMS et réactions publiques.

L’algorithme « Lavender » a assisté au ciblage de membres présumés du Hamas, malgré des prédictions imparfaites.

La coopération entre l’unité 8200 et des réservistes issus de Google, Meta et Microsoft a accéléré le déploiement massif de ces outils en temps réel.

🔍 DECRYPTAGE

Ces révélations confirment un tournant : la conduite des hostilités passe désormais par des algorithmes capables de générer des centaines de cibles par jour, loin du rythme humain. L’argument militaire — localiser plus vite les commandants ennemis et sauver des otages — se heurte à la réalité d’un bout de code qui tolère un fort « bruit » civil. En interne, Tsahal promet que chaque frappe reste validée par un officier ; mais plus l’IA automatise l’identification, plus la validation ressemble à un clic reflexe. L’affaire convoque un dilemme éthique déjà soulevé par l’ONU : peut-on déléguer à une machine la « licence de tuer » quand ses marges d’erreur se comptent en vies ? La course à l’IA militaire a commencé ; la transparence, elle, reste en file d’attente.

🤔 Contre-pied

« AGI » : un mot qui trompe

⚡ EN BREF

Dans une tribune publiée sur LinkedIn, Benoît Bergeret, expert français en intelligence artificielle et en gouvernance technologique, démonte la notion d’« intelligence artificielle générale » : un slogan qui, selon lui, masque les vraies questions de pertinence, d’usage et de pouvoir économique.

🎯 A RETENIR

Le terme « AGI » réduit l’intelligence humaine à un score de QI et occulte intuition, empathie et ancrage social.

La « course à l’AGI » sert surtout de levier marketing pour lever des milliards, exemple : projet Stargate à 500 G $.

Bergeret propose la notion d’« IA pertinente » : valeur mesurée à l’aune d’un contexte précis, pas d’une imitation globale de l’homme.

Il défend le concept d’« holobionte cognitif » : l’intelligence émerge des interactions entre humains, outils et culture.

La polarisation pro- / anti-AGI détourne le débat essentiel : quels usages voulons-nous démocratiquement déléguer à la machine ?

🔍 DECRYPTAGE

En épinglant l’AGI comme une « religion à 500 milliards », Bergeret rappelle que le vocabulaire façonne la stratégie. Tant que les géants vendront une promesse vague d’esprit métallique, ils pourront réclamer toujours plus de capital et d’indulgence réglementaire. Parler d’« IA pertinente », c’est renverser la perspective : exiger des preuves d’utilité locale, d’alignement éthique et d’impact environnemental concret. Le propos résonne avec le scepticisme grandissant de chercheurs comme LeCun ou Chalmers : le futur de l’IA n’est pas un cerveau désincarné, mais un maillage d’outils qui étendent nos capacités tout en restant tributaires de nos choix politiques. À l’heure où la moitié de la filière rêve de scores SAT pour séduire Wall Street, rappeler que « mal nommer les choses, c’est ajouter au malheur du monde » sonne comme une invitation salutaire à reprendre le contrôle du récit.

EN VRAC

🛠️ Outils

OpenAI ouvre son générateur d’images

OpenAI ouvre gpt-image-1 dans son API, permettant à n’importe quel service d’intégrer le générateur d’images nouvelle génération. Déjà adopté par Adobe, Figma ou Wix, c’est le seul modèle grand public capable d’itérations aussi précises sur les images. Attendez-vous à le voir bientôt partout.

🏛️ Gouvernance

OpenAI sous le feu des critiques

Un collectif d’experts et d’anciens employés dénonce le projet de restructuration d'OpenAI, qui transférerait le contrôle de l’AGI d’une fondation à une entité privée. Selon eux, cela viole l'engagement initial d'œuvrer pour l’intérêt général et mettrait le futur de l’IA au service d’intérêts commerciaux.

👥 Société

Hassabis alerte sur les risques de l’AGI

Dans un entretien au TIME, Demis Hassabis, prix Nobel et patron de DeepMind, alerte lui aussi sur l’AGI : armes biologiques, agents manipulateurs, robots incontrôlables. DeepMind collabore pourtant avec des armées, écornant son image de garant éthique.

📈 Business

El Salvador : après les cryptos, les prisons, l'IA

Après avoir légalisé le Bitcoin et construit des prisons géantes pour migrants et gangs, El Salvador, encore dans l’actu en s’alliant à Nvidia pour créer une infrastructure d’IA nationale. Objectif : former des développeurs, renforcer santé, éducation et économie.

🛠️ Outils

Deux étudiants défient ElevenLabs avec Dia

Sans budget, deux étudiants ont créé Dia, un modèle vocal rival des leaders du marché, en s'appuyant sur les TPUs de Google. Leur application arrive bientôt. 📖 Source : VentureBeat

👥 Société

Des employés IA dans un an ?

D’ici un an, des IA autonomes capables de gérer leurs propres accès et rôles pourraient s’imposer dans les entreprises. Jason Clinton (Anthropic) avertit : sans contrôle strict, ces agents pourraient pirater des réseaux entiers sans qu’aucun humain ne puisse être tenu responsable. 📖 Source : Axios