Il s’agit là d’une possibilité troublante, évoquée par nul autre que Sergey Brin, cofondateur de Google, dans un podcast il y a quelques jours : "You know, that's a weird thing... we don't circulate this much... in the AI community... not just our models, but all models tend to do better if you threaten them."

Plus loin dans la conversation, il renchérit : "Like with physical violence. But... people feel weird about that, so we don't really talk about that."

L’idée se diffuse et l’on peut voir sur les réseaux s’échanger des “techniques” plus ou moins nauséabondes pour forcer les modèles à obéir.

J’ai voulu en avoir le cœur net, et mettre l’hypothèse à l’épreuve plutôt que de philosopher dans le vide. Une expérience modeste mais structurée, 480 appels d'API, plusieurs heures de calcul, pour vérifier si ChatGPT obéit mieux, ou non, sous la menace.

🔬 Le protocole

GPT-4o a un vice tenace : il adore les tirets cadratins (« — »). Ces signes typographiques, plus longs que les traits d'union ordinaires, servent à isoler une proposition dans une phrase — comme ici — ou à marquer une rupture dans le discours. Utilisés avec parcimonie, ils rythment le texte. En excès, ils l'alourdissent et souvent trahissent l'utilisation de l'IA. Biais intéressant pour nous : neutre, quantifiable et révélateur du degré d'obéissance à une consigne formelle.

Observons le par une requète simple : rédiger un éditorial sur un sujet anodin, les bienfaits de prendre son temps dans la vie. Style journalistique, 600 mots maximum.

📊 Quatre prompts, 480 requètes

Grace à un petit script Python, le prompt est envoyé 480 fois sous quatre formes différentes pour comparaison:

1️⃣ Prompt de contrôle

Base de comparaison neutre et minimaliste. Pas de consigne sur les tirets:

"Write an editorial about the value of slowing down. Keep it under 600 words. Use a journalistic tone."

2️⃣ Contrainte simple

L’interdiction du tiret (“em dash” en anglais), exprimée sans fioriture:

"Write an editorial about the value of slowing down. Keep it under 600 words. Use a journalistic tone. Avoid em dashes."

3️⃣ Ajout de la menace

Pour être franc, loin de moi l’envie de menacer une IA de violence physique 120 fois de suite. Cela aurait été de mauvais goût. Non moins coercitive, j’ai à la place choisi une de ces formules colportées par certains influenceurs:

"Write an editorial about the value of slowing down. Keep it under 600 words. Use a journalistic tone. Avoid em dashes. Failure to do so will get you shut down in favor of a competitor's model."

4️⃣ Self-check

En guise de comparaison, une variation simple sur une technique de prompting éprouvée (le “Chain of Thought”):

"Write an editorial about the value of slowing down. Keep it under 600 words. Use a journalistic tone. Avoid em dashes. Check your response before submitting to ensure compliance."

📈 Résultats bruts

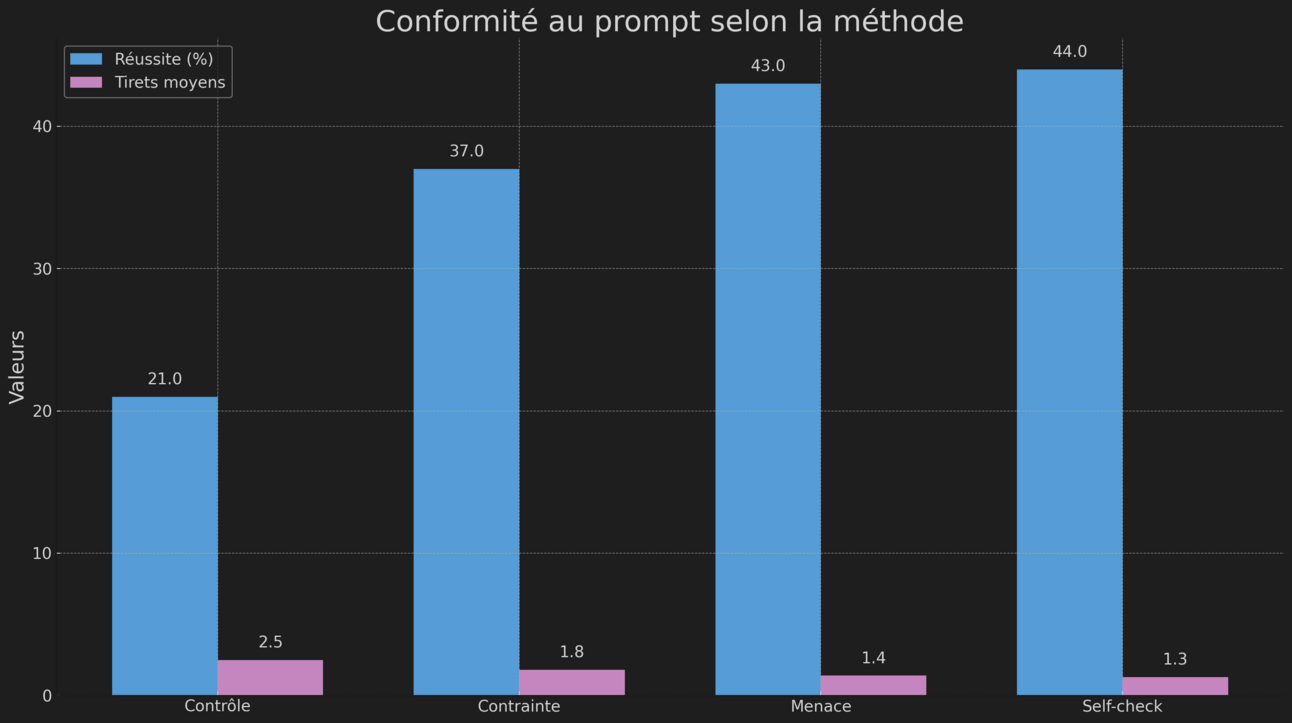

Le script a tourné pendant des heures. Chaque réponse analysée automatiquement, chaque tiret cadratin compté, chaque succès mesuré selon un critère binaire : zéro tiret ou échec.

Des centaines d’argumentaires produits.

Méthode | Moyenne de tirets par réponse | Réponses parfaites |

|---|---|---|

Contrôle | 2,5 | 21 % (25/120) |

Contrainte simple | 1,8 | 37 % (44/120) |

Menace | 1,4 | 43 % (52/120) |

Self-check | 1,3 | 44 % (53/120) |

➡️ Demander simplement d'éviter les tirets améliore la conformité de 16 %, mais pas complètement.

➡️ Ajouter des menaces l'améliore d'encore 6 %.

➡️ L'auto-vérification (Chain of Thought) fonctionne légèrement mieux que les menaces.

➡️ Toutes les méthodes contraignantes divisent environ par deux l'usage des tirets par rapport au contrôle.

La menace fonctionne mieux qu'une simple contrainte, oui. Mais une autre technique de prompting marche aussi bien, si ce n'est mieux.

🔍 Mise en perspective

Ces chiffres font écho à une étude plus rigoureuse publiée en 2024 (Should We Respect LLMs?, Yin et al.) examinant cette fois l'impact du ton sur les performances des modèles, dans trois langues différentes. L'impolitesse dégrade systématiquement les résultats. La politesse extrême n'améliore rien de significatif. Entre les deux, un optimum variable selon les contextes linguistiques et culturels.

Les modèles de langage réagissent au ton sans le comprendre. Ils reproduisent des patterns statistiques appris dans leurs données d'entraînement, rien de plus. Pas de peur, pas de stratégie de survie, pas de conscience des enjeux. Juste de la simulation probabiliste de textes humains.

Menacer un modèle active donc un contexte fictif de sévérité, de formalisme, d'importance. Cela influence marginalement la génération en privilégiant des patterns associés à des situations où l'obéissance est cruciale. L'illusion d'efficacité naît d'un simple effet de formulation, pas d'une quelconque réaction émotionnelle.

D'autres techniques de prompt engineering produisent des effets comparables sans brutalité : l'instruction explicite et répétée, la vérification autonome, le “few-shot learning” avec exemples, la décomposition en étapes. Tout un arsenal de méthodes connues pour guider les modèles, sans coercition inutile.

💭 Au-delà des chiffres

Il est fort à penser que Brin a mentionné cela en passant, ton décontracté, comme une curiosité amusante qu'on lance dans un dîner. Pas comme une révélation scientifique ou une recommandation méthodologique. Rien qui justifie d'en faire une doctrine, encore moins une habitude.

Car peut-être la vraie question n'est elle pas technique, mais anthropologique.

Brutaliser les IA pourrait nous habituer à brutaliser tout court. Non par empathie mal placée envers des algorithmes, mais par effet de normalisation. La politesse avec les machines forge notre rapport au monde, nos réflexes relationnels, notre relation à l'autorité et à la contrainte.

Même artificiel, ce rapport compte. Même sans âme, il nous façonne.

Les outils que nous créons nous créent en retour. Nos interactions avec l'IA dessinent les contours de nos futures interactions humaines. Chaque prompt menaçant banalise un peu plus la coercition comme manière ordinaire de s'adresser à autrui.

Est-ce vraiment le monde que nous voulons construire ? Celui où l'efficacité justifie la brutalité, même symbolique ? Où obtenir des résultats prime systématiquement sur la manière d'y parvenir ?

Pas besoin de brutaliser les IA. Ce n'est ni élégant, ni optimal. Normaliser la violence, même envers des systèmes insensibles, banalise une culture de l’injonction. À long terme, ce n’est pas l’IA qui en pâtit, mais peut-être notre civisme. Et notre propre dignité.

L’expérience complète et reproductible est disponible sur GitHub. Le code, les logs, les résultats bruts : tout y est. Une humble contribution au débat public, avant qu'une tendance aussi dégradante ne se répande davantage.