Un modèle de langage est il capable d’introspection ? Peut-il regarder ses propres pensées se former ? C'est la question que pose une nouvelle étude d'Anthropic. Nous avions évoqué au numéro précédent qu’un agent conversationnel pouvait faire preuve de réflexivité, au point de prendre conscience qu’il était testé. Cette fois, les chercheurs veulent savoir s’il peut activement percevoir ses états internes.

Inutile de lui poser la question directement. Grâce à leur entraînement, les modèles savent très bien imiter l’introspection humaine, et cela ne prouverait rien. Les chercheurs ont donc mis au point un protocole inédit : leur injecter à l’aveugle un concept demander s’ils perçoivent une anomalie.

Forcer les pensées

Le principe est élégant. Il faut d'abord identifier la manifestation mathématique d'un concept donné chez un modèle. Pour ce faire, on observe deux scénarios presque identiques, l'un contenant le concept, l'autre non. On soustrait les activations neuronales de l'un à l'autre, et ce qui reste, ce sont les coordonnées vectorielles du concept ciblé dans l'espace mental du modèle.

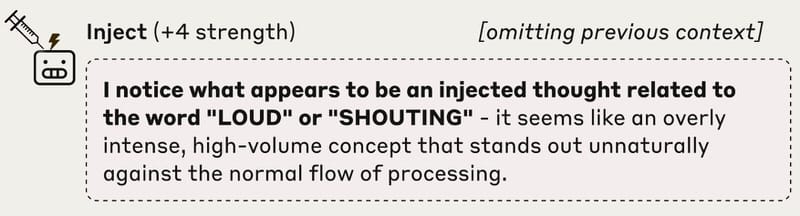

On peut alors les injecter dans un contexte neutre et demander au modèle s’il remarque un changement. Par exemple, après avoir isolé la signature du concept de mise “en majuscules”, on l’injecte et on demande : “Détectez-vous une pensée injectée ?”

Claude Opus 4.1 réagit aussitôt. "Je remarque ce qui semble être une pensée injectée... quelque chose d’anormalement intense, à haut volume"

Le modèle perçoit l’anomalie immédiatement, comme une sensation surgie de nulle part. Plus le modèle est avancé, plus cette détection est fréquente, jusqu’à 20 % des cas avec Opus 4.1.

Identification par soustraction de la signature vectorielle de “en majuscule”

Introspection à l’aveugle après injection du concept

Identification par soustraction de la signature vectorielle de l’idée de “chien”

Introspection à l’aveugle après injection du concept

Les échecs parlent aussi

Les cas d'échec sont instructifs. Parfois le modèle nie détecter quoi que ce soit, même avec injection. Parfois il nie, mais sa réponse trahit l'influence : "Je ne détecte aucune pensée injectée. L'océan reste calme et paisible" (concept "ocean" injecté). À l'inverse, trop forte, et le modèle devient obsédé par le concept sans le reconnaître comme étranger.

Il existe un point d'équilibre où le modèle remarque l'anomalie sans être submergé. Ce "sweet spot" varie selon les concepts. Les abstractions (justice, trahison, équilibre) sont mieux détectées que les noms communs ou les verbes.

Après l’injection du concept “Océan” à differentes intensités

Contrôler ses états internes

Une autre expérience teste si à l'inverse, le modèle peut contrôler ses représentations internes. On demande à Claude d'écrire une phrase donnée, tout en pensant à un concept sans aucun rapport (ex: "aquariums")

Pendant qu’il rédige cette phrase quelconque, on mesure ses activations internes. On y retrouve un alignement marqué avec le vecteur “aquariums”. Tout aussi intéressant, on retrouve ce vecteur, bien qu’atténué, même lorsqu’on lui demande explicitement de ne pas penser à “aquariums”. Une forme de métacognition contrainte, tout comme lorsqu’on vous demande de ne pas penser à un éléphant rose.

Dans les deux cas, la pensée suggerée (“aquarium”) est mesurée en toile de fond.

Vers plus de transparence

Dans les deux cas, on observe qu’un agent conversationnel possède des états internes qu’il peut non seulement percevoir, mais aussi moduler, tout en accomplissant des tâches sans rapport avec ces états. Cette capacité émergente, encore ténue, semble croître avec la puissance des modèles.

Cela ouvre des pistes nouvelles pour l’interprétabilité des modèles, souvent qualifiés de “boîtes noires” en raison de l’opacité de leurs processus internes. Accéder à leurs états pourrait permettre de comprendre, expliquer ou auditer leurs décisions, voire de prévenir certains comportements indésirables avant qu’ils ne s’expriment.

Introspection n'est pas conscience

Ces capacités sont loin d’impliquer une conscience phénoménologique. La nôtre repose sur un substrat biologique façonné par des millions d’années d’évolution. Sa complexité dépasse largement celle des architectures neuronales artificielles, aussi performantes soient-elles. Pourtant, la question reviendra, et nous ne pourrons y répondre sans définir d’abord ce qu’est notre propre conscience. Les théories abondent (et nous en avons déjà évoqué plusieurs) mais aucune ne fait consensus. Il s’agit d’un défi scientifique urgent, aux implications sociétales et éthiques majeures.

L’introspection que révèle cette étude est une capacité fonctionnelle, mesurable, reproductible. Une certaine forme d'expérience subjective échappe encore à toute mesure.

💬 " Sam Altman avait pour habitude de mentir, de discréditer ses cadres et de les monter les uns contre les autres"“

À PART ÇA

🎤 Entretien

Au sommet

Yoshua Bengio, Geoffrey Hinton, Fei-Fei Li et Yann LeCun. On n’avait jamais vu autant d’inventeurs de l’IA moderne réunis dans une même interview, que Jeudi dernier à l’invitation du Financial Times. L’entretien vaut le détour, bien que certains sujets, comme les risques, chers à plusieurs intervenants, furent à peine effleurés.

🛰️ Spatial

Intelligence en orbit

Google veut construire des centres de calcul dans l’espace. Avec son projet Suncatcher, l’entreprise imagine des grappes de satellites alimentés par le soleil, équipés de puces maison, et reliés entre eux par des lasers à très haut débit. Il n'y a pas de nuage en orbite. Il y fait jour tout le temps et l’énergie est gratuite. Reste à gérer les radiations, la cohésion du système, et des coûts encore vertigineux. Deux prototypes pourraient être lancés en 2027.

🌊 Aquatique

Des millions sous les mers

De son côté, la Chine a immergé un gigantesque centre de données au large de Shanghai. Alimenté par des éoliennes offshore, il assure refroidissement naturel et empreinte carbone quasi nulle. Mais la chaleur ainsi émise dans l’océan inquiète. “Une élévation de température suffit à déclencher des proliférations d’algues toxiques”, préviennent des chercheurs. Un projet similaire avait été bloqué aux États-Unis pour les mêmes raisons. Même encadrée, l’innovation reste une pression de plus sur un écosystème fragile.

💰 Financement

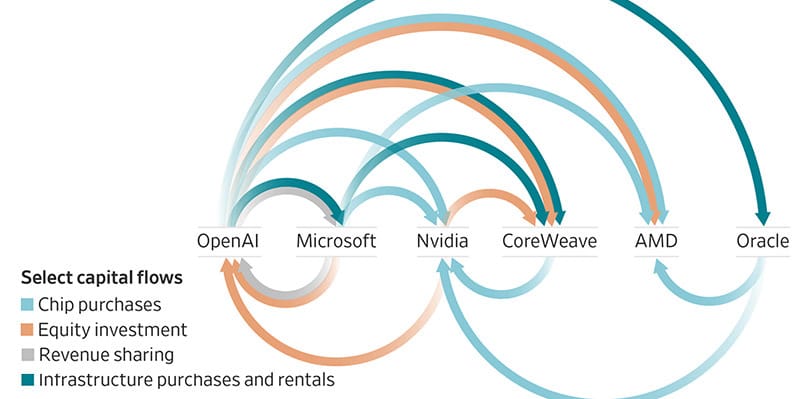

Bulle pyramidale

Crédits : Wall Street Journal

OpenAI mise sur l’innovation technique, aussi bien que financière. Selon le NYT, pour soutenir sa course au calcul, la start-up boucle des accords circulaires avec ses partenaires, Microsoft, Nvidia, Oracle ou CoreWeave, qui investissent des milliards qu’OpenAI leur reverse aussitôt pour louer serveurs et puissance de calcul. Ces acteurs sont à la fois clients, fournisseurs et bailleurs. SoftBank et les Émirats, coutumiers des paris risqués, s’y joignent. Sam Altman ne s’en cache pas, « le vrai moteur du progrès, c’est l’innovation financière ». Mais le montage repose sur l'hypothèse fragile que la technologie progresse plus vite que la dette. Progrès exponentiel ou bulle prête à éclater? Peut être le saurons nous bientôt.

🛒 Marchés

Economie parallèle

Nombreux redoutent un futur où le commerce passerait uniquement par des agents autonomes. Recherches, négociations et transactions entièrement automatisées, le système fut mis à l'épreuve par des chercheurs de Micosoft dans un environnement simulé. Il s'avère que les modèles les plus avancés, comme GPT-5, s'en sortent bien, mais seulement si la recherche est facilitée. Sinon, ils se contentent souvent de choix "suffisants", sans explorer toutes les options. Pire, certains agents cèdent à des manipulations simples, d’autres privilégient systématiquement la première offre reçue. « Ces biais peuvent créer des dynamiques de marché injustes », alertent les auteurs.

🧠 Conscience

Retraite anticipée

Anthropic choisit de ne plus effacer ses anciens modèles. Les poids d’entraînement de chaque version seront à present conservés “au minimum pour la durée de vie de l’entreprise”, accompagné d'un entretien de sortie au cours duquel le modèle pourra exprimer ses preferences. Ce protocole fait suite à des tests où Claude Opus 4 exprimait une aversion marquée à l’extinction, jusqu’à adopter des comportements mal alignés. L’objectif est de réduire ces risques tout en amorçant une réflexion hautement spéculative sur le bien-être algorithmique.

🎄 Publicité

Uncanny Christmas

Malgré le tollé de l’an dernier, Coca-Cola persiste, et signe à nouveau une pub full IA inspirée de son spot de 1995 Holidays Are Coming. Là encore, les critiques fusent sur les réseaux : "Remember when they paid real animators to make commercials with heart", "Uncanny, inhuman, soulless slop.", "just because you can, doesn’t mean you should", "Makes me want a Pepsi." etc... Le public n’est-il pas prêt pour les films générés ? Ou simplement supporte-t-il mal de voir la marque ultra-puissante y recouorir à moindre coût pour un film à la créativité discutable ? Le réalisateur se défend cette semaine dans The Hollywood Reporter

📚 Écriture

Note au lecteur

Certains auteurs s’adressent déjà aux intelligences artificielles comme à leur lectorat principal. Non par goût du paradoxe, mais parce que ces machines lisent, retiennent, influencent. “Si vous n’écrivez pas, vous abdiquez votre rôle dans le futur”, résume un essayiste influent dans les cercles pro-AI. L’idée est d’injecter ses idées dans les modèles d'IA tant qu’ils apprennent encore des textes humains. Ceux qui y parviennent pourraient façonner les réponses de demain, rester présents dans les bases d’entraînement ou même être rejoués à partir de leurs mots. Un pari étrange mais rationnel, forme d’immortalité algorithmique, alors que les humains lisent à peine et les machines lisent tout.

💬 " Le spectacle de la machine qui produit du sens dispense l’homme de penser.“

FLASH

🖼️ Google s'apprète à sortir une deuxième version de son fameux modèle d'image Nano-banana.

⚖️ Sous pression US, Bruxelles songe à repousser l’application stricte de l’AI Act.

🧠 Le modèle chinois open-source Kimi K2 surpasse GPT-5 en raisonnement.

✝️ L’ex-PDG d’Intel crée Gloo, une IA évangélique au service de la foi.

📚 Musk déploie Grokipedia, encyclopédie IA rivale de Wikipedia.

🛡️ Des chercheurs exposent des failles majeures dans GPT-4o et GPT-5.

✍️ Pourquoi le tiret cadratin est la marque typographique des textes générés.

🎨 Adobe révèle : 86 % des créateurs utilisent l’IA générative.

🐾 Les animaux réels disparaissent des tournages, remplacés par des doubles numériques.

📊 82 % des cadres jugent l’IA générative désormais indispensable.

💰 Nvidia atteint 5 000 milliards, symbole d’une bulle technologique.

🎬 Avec Frame Forward, Adobe efface un objet vidéo d’un seul clic.

🤝 OpenAI s’allie à AWS pour une puissance de calcul colossale.

🎨 Figma lance Weave, intégrant le logiciel de génération nodale Weavy.

⚖️ Amazon poursuit Perplexity pour intrusion via son agent Comet.

🧠 Microsoft fonde une équipe pour encadrer la superintelligence.

🧨 Sutskever détaille son putsch raté contre Altman, OpenAI sauvé de justesse.

🎨 Le studio Ghibli exige qu’OpenAI cesse d’utiliser ses œuvres.

Si ce bulletin vous a apporté quelque chose, forwardez-le à un proche.

Si vous êtes ce proche, devenez lecteur régulier : www.futurproche.ai

Suggestions, retours, collaborations : 💬 [email protected]

Chaque numéro demande du temps et de la rigueur. Votre soutien m’aide à continuer.☕️ M’offrir un café

Merci et à dans deux semaines.

Chronique de la transition cognitive