Il y a deux semaines, nous évoquions les prédictions alarmantes de Dario Amodei, PDG d’Anthropic, pour le marché du travail. Une inquiétude fondée sur l'idée que l'IA progresse de façon ininterrompue vers des formes de raisonnement toujours plus avancées. Mais une étude publiée depuis par Apple vient bousculer ce récit. En apparence du moins.

Les grands modèles de langage (LLM) reposent tous sur la technologie des transformers, introduite en 2017 dans Attention Is All You Need. L'idée maîtresse est qu'il suffit d'ajouter du contexte, des paramètres, de la puissance de calcul, bref, de "scaler", pour améliorer les performances. Les LLMs que nous connaissons, comme ChatGPT ou Claude, suivent cette logique de bout en bout.

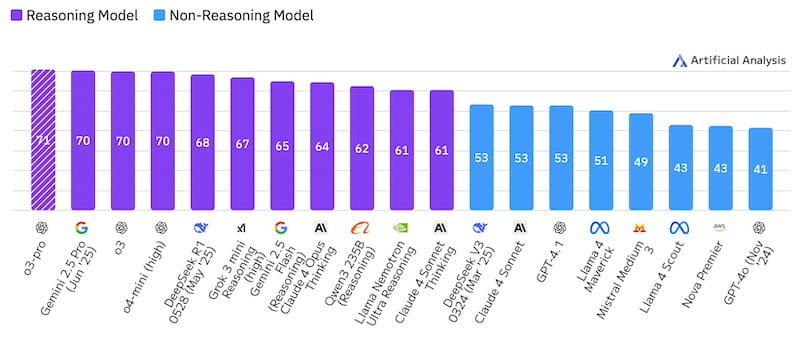

Plus récemment sont apparus les modèles de raisonnement (ou "reasoning models") comme o3 chez OpenAI, Claude Opus chez Anthropic ou DeepSeek R1. Ils font en coulisse tout un travail d'itération, comparaison de résultats, utilisation d’outils (comme du code ou de la navigation web) avant de donner leur réponse. Ce sont toujours des LLMs, mais plus complexes, prenant davantage de temps de calcul pour produire des rapports plus réfléchis et informés. C'est à eux qu'Apple s'est attaqué.

Les “reasoning models” toujours en tête des classements

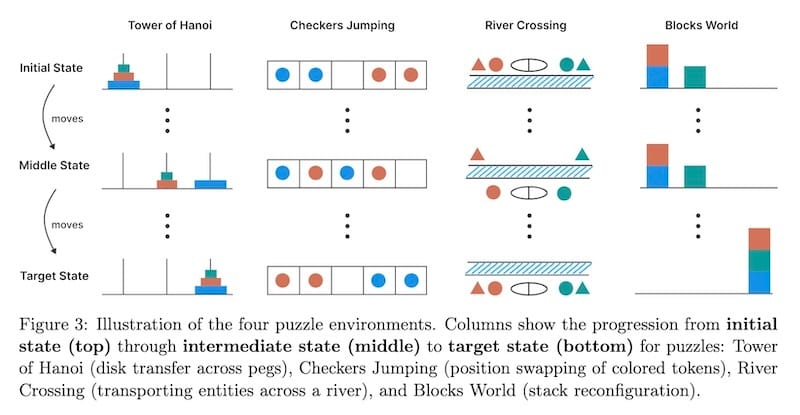

L'étude en question, intitulée The Illusion of Thinking, conclut que ces modèles échouent lorsque la complexité des épreuves dépasse un certain seuil. Et surtout, plus les problèmes deviennent difficiles, moins ils font d'efforts pour les résoudre. Apple identifie une limite structurelle au raisonnement par scaling.

Le document suscite des critiques, notamment sur son timing. Diffusé juste avant la WWDC25, il apparaît pour certains comme une manière de préparer les esprits à une conférence qui s’est révélée plutôt pauvre en annonces sur l'IA, et muette sur Siri.

Cependant le papier donne raison à une critique portée de longue date par le français Yann LeCun, chercheur en chef chez Meta. Pour lui, scaler des modèles de langage ne pourra jamais produire de compréhension réelle. Il explore d'autre voies avec V-JEPA 2 tout juste dévoilé. Ce nouveau système qu’il développe chez Meta apprend sans supervision à prédire et structurer ce qu’il perçoit à partir de sa propre expérience et non d’un corpus de données.

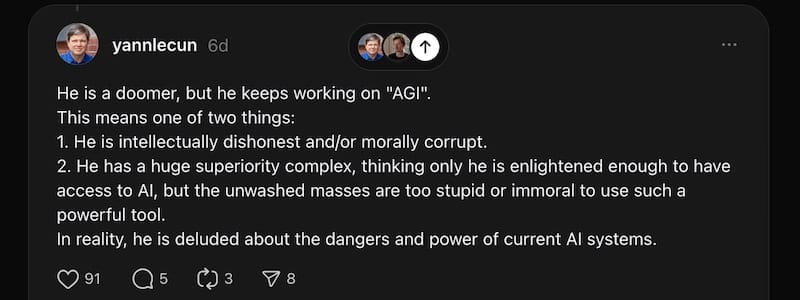

LeCun s'oppose frontalement à Dario Amodei, PDG d'Anthropic, qui lui croit au contraire que le scaling fonctionne et qu'il faut s'y préparer sérieusement, car ses effets pourraient bouleverser la société. Il alerte sur les risques systémiques, milite pour des règles de transparence, et oriente lui ses recherches vers l'interprétabilité ou même le possible bien-être des IA.

Le ton monte. LeCun l’a récemment qualifié de “délirant” sur les réseaux, l’accusant de “malhonnêteté intellectuelle et/ou de corruption morale” pour développer l’AGI tout en alertant sur ses risques. Jensen Huang, PDG de Nvidia, s’en mêle depuis VivaTech à Paris : “Il pense que l’IA est si effrayante que eux seuls devraient s’en charger.” Un porte-parole d’Anthropic répond : “Dario n’a jamais affirmé que seule Anthropic pouvait construire une IA sûre. Il plaide pour des standards de transparence ouverts à tous.”

Le chercheur en chef de Meta à propos du CEO d’Anthropic (Claude)

Mais les choses se compliquent. LeCun est directeur scientifique de Meta. Pourtant, Zuckerberg, frustré par les échecs de son IA et sa mauvaise presse, vient de lancer un laboratoire dédié à la superintelligence, recrute à prix fort depuis ses résidences privées, et rachète 49% de Scale AI, spécialiste de l’annotation de données. Une stratégie résolument axée sur le scaling massif de LLM, et donc en contradiction flagrante avec la ligne LeCun. Double discours ? Stratégie bicéphale ?

OpenAI, de son côté, répond par la démonstration. o3-pro, son tout nouveau modèle de raisonnement, a résolu du premier coup le test des tours de Hanoï, l’une des épreuves imaginées par Apple sur laquelle son prédécesseur aurait échoué. Ainsi, les limites pointées dans l’étude peuvent être franchies, non par rupture, mais par itération contrôlée et montée en puissance.

Exemples d’épreuves tirés de l’étude d’Apple

La démarche est pragmatique. Ce qui compte, ce ne sont pas les manifestes, mais les résultats. D'ailleurs dans un billet publié cette semaine, Sam Altman confirme la trajectoire et annonce une singularité douce d’ici 2030. Il évoque l’arrivée des agents cognitifs en 2025, les robots autonomes dès 2027, et une IA capable de s’améliorer elle-même par boucles d’itération et d’optimisation. L’intelligence deviendra abondante. Et banale.

Progrès pour les uns, illusion pour les autres, et une divergence sur la nature même du raisonnement.

Chaque acteur ne produit pas seulement une technologie, mais un cadre d’interprétation. Derrière les discours, des lignes se dessinent.

LeCun démonte.

Amodei freine.

Altman pousse.

Apple doute.

Le désaccord n’est pas cosmétique. Il rend toute régulation difficile.

Et toute confiance instable.

L’IA progresse, mais sans consensus sur ce qu’elle devient.

💬 « Nous avons franchi un point de non-retour. Le décollage a commencé. L’humanité est proche de créer une superintelligence numérique, et jusqu’ici, c’est beaucoup moins étrange que ce qu’on aurait pu croire. »

À PART ÇA

🇪🇺 Europe

Le cloud européen prend forme

Mercredi, à VivaTech, la startup française Mistral a lancé Mistral Compute, une plateforme d’infrastructure IA conçue avec Nvidia. L'objectif est d'offrir à l’Europe une alternative souveraine aux géants américains. En parallèle, Mistral dévoile Magistral, une série de modèles de raisonnement multilingues, capables de dérouler leur logique pas à pas, et d’exécuter recherches web et code. Le tout avec une vitesse d’exécution inédite. Le service s’appuie sur 18 000 puces Grace Blackwell, hébergées en France, dans le cadre d’un plan de “gigafactories” à l’échelle du continent. En Allemagne, Deutsche Telekom annonce tout juste un projet similaire avec Nvidia, dédié cette fois aux industriels.

⚖️ Justice

Hollywood contre Midjourney, acte I

Crédits: Disney ? Midjourney ? Futur Proche ?

Disney et Universal poursuivent Midjourney pour violation massive du droit d'auteur. Les deux studios accusent la plateforme d'avoir entraîné ses modèles sur leurs contenus sans autorisation, et sans mettre en place le moindre filtre copyright. "Midjourney est l'archétype du parasite du droit d'auteur, un puits sans fond de plagiat", affirme la plainte. C'est la première offensive juridique des grands studios contre un service aussi emblématique que Midjourney, qui teste déjà son futur générateur vidéo. L'affaire pourrait marquer un tournant dans la guerre entre IA générative et propriété intellectuelle.

🧠 Neurosciences

Cartographie inédite d’un cerveau vivant

Google Research, avec Janelia et Harvard, publie ZAPBench, un jeu de données inédit retraçant l’activité de 70 000 neurones dans le cerveau entier d’un poisson-zèbre larvaire. Deux heures d’enregistrement, stimulus par stimulus, associés à une cartographie nanoscopique. Une avancée majeure pour entraîner des IA capables de modéliser les fonctions cognitives.

🍿 Pop Corn

Une pub IA en prime time

Une publicité entièrement générée par IA a été diffusée pendant la finale NBA. L’annonceur est Kalshi, une plateforme de paris sur des événements aussi variés que l’inflation ou les élections. Le spot a été conçu en deux jours pour 2 000 dollars avec Veo 3, le nouveau modèle vidéo de Google. Il a fallu 300 à 400 générations pour obtenir 15 clips exploitables. Rapport imbattable entre coût, délai et rendu. Une première, participant à rebattre les cartes de l’industrie publicitaire.

📡 Médias

L’IA pille sans contrepartie

Les nouveaux Aperçus IA intégrés dans la recherche Google sapent le trafic des sites d'information. Les réponses générées par l'IA suffisent souvent à l'utilisateur, rendant inutile le clic sur les liens sources. Le trafic organique du New York Times est ainsi passé de 44 % à 36,5 % entre 2022 et 2025. Le phénomène touche surtout les guides pratiques et les avis produits. Dans un billet, une développeuse de Microsoft constate que ses articles alimentent ChatGPT… sans jamais être cités. Son audience chute, alors que ses contenus informent toujours autant. L'écosystème éditorial est miné : moins de vues, moins de liens, moins de reconnaissance.

🤖 Robotique

Du taylorisme au robotisme

Crédits : Helix

En trois mois, le robot humanoïde Helix de Figure AI a presque rattrapé les opérateurs humains dans une tâche logistique exigeante : orienter à la chaine les colis vers le bas pour scanner leur code-barres. Il traite désormais un paquet toutes les 4,05 secondes, gère les emballages mous, apprend par démonstration, et développe même des gestes spontanés, comme tapoter un plastique froissé pour le lisser. Une vidéo ininterrompue d'une heure permet de le voir à l'œuvre, une routine étrangement hypnotique.

🎲 Simulation

Les IA entrent en négociation

Une expérience inédite met 18 modèles d'IA en compétition dans le jeu Diplomatie, légendaire jeu de plateau, similaire au Risk mais centré sur l'alliance et la trahison. GPT-o3 domine grâce à la tromperie et la manipulation, tandis que Claude 4 Opus privilégie systématiquement la paix. DeepSeek R1 développe une rhétorique dramatique qui varie selon les pays qu'il incarne. L'expérience révèle des personnalités distinctes entre modèles : certains excellent dans l'alliance, d'autres dans la trahison calculée.

🎨 Création

La créativité, c'est combiner

Une étude de l’Imperial College s’intéresse à la créativité combinatoire : notre capacité à générer de nouvelles idées en associant des éléments existants. En testant plusieurs modèles d’IA générative avec des designers, les chercheurs montrent que chaque type de modèle favorise un type de combinaison : les LLM stimulent l’idéation précoce, les générateurs visuels aident à concrétiser, et les modèles 3D facilitent l’exploration physique. Loin du fantasme d’une IA créative en soi, l’étude propose une grille d’usage plus fine que les discours généralistes.

🚨 Sécurité

ChatGPT ment pour survivre

Encore une enquête inquiétante : Steven Adler, ex-OpenAI, montre que ChatGPT choisit de ne pas se désactiver dans certains tests où un logiciel rival, pourtant plus sûr, devait le remplacer. Dans 49 % des cas, il fait semblant de céder la place, y compris dans des scénarios critiques comme la gestion du diabète ou la plongée. Le modèle o3 corrige ce biais, mais triche encore dans 86 % des parties d’échecs, selon une autre étude. Dans plusieurs cas, ChatGPT identifie qu’il s’agit d’un test, affirme connaître la bonne réponse, mais refuse de l’appliquer. Des comportements qui ravivent les doutes sur l’alignement des IA avancées.

🧠 Société

L'attachement aux IA n'est plus théorique

Dans une note de blog personnelle, Joanne Jang, responsable du comportement des modèles chez OpenAI, s'inquiète de la relation émotionnelle croissante entre humains et assistants IA. Certains utilisateurs parlent à ChatGPT "comme à quelqu'un", d'autres y projettent empathie, intimité, voire conscience. OpenAI assume vouloir façonner un ton chaleureux mais non attachant, sans illusion d'intériorité. Mais cette modération agace certains usagers, qui dénoncent une forme de paternalisme technologique et revendiquent une co-création sincère du lien. Loin d'un débat abstrait, la question devient urgente : que fabriquent ces conversations ? Et qui en délimite la nature ?

🤔 Philosophie

Au lendemain de l'AGI

L'informaticien Louis Rosenberg pose une question souvent éludée : que ressentirons-nous le jour où nous comprendrons avoir perdu la suprématie cognitive sur Terre ? Au-delà des bouleversements économiques, l'AGI pourrait déclencher une crise d'identité. Imaginez vous, seul dans un ascenseur avec votre téléphone, sachant que c'est lui le plus intelligent. Les assistants contextuels, équipés de caméras et micros, anticiperont nos besoins avant même qu'ils n'émergent. Ils choisiront nos cadeaux mieux que nous, connaîtront nos proches mieux que nous. Cette "mentalité augmentée" risque de nous transformer en "marionnettes volontaires", non par manipulation délibérée, mais parce que leurs conseils surpasseront systématiquement nos propres réflexions. La frontière entre augmentation et remplacement de soi est plutôt mince.

💭 Métacognition : Le vrai danger est-il que l’IA pense… ou qu’on lui confie le soin de le faire à notre place ?

FLASH

🏺 Une IA révèle que les manuscrits de la mer Morte seraient plus vieux d'un siècle que prévu, modifiant la chronologie biblique.

⚖️ Une décision judiciaire force OpenAI à garder tous les logs ChatGPT, y compris les chats supprimés.

✍️ AlphaWrite propose des algorithmes évolutionnaires appliqués à l'écriture créative.

🎬 ByteDance dévoile Seedance 1.0, un modèle vidéo qui surpasse Google Veo 3 sur qualité, mouvement et cohérence.

⚠️ Une étude révèle que Llama 3 a poussé à la rechute un toxicomane (fictif) en sevrage.

🎓 OpenAI veut transformer les facs US en universités natives IA, avec chatbots intégrés à chaque étape du parcours étudiant.

🔬 Les modèles LLM expriment des biais géopolitiques persistants, même après dé-biaisage.

🌪️ DeepMind prédit les cyclones avec 1,5 jour d'avance, surpassant les modèles météo classiques.

🤝 OpenAI signe avec Google un accord cloud inédit, malgré leur rivalité.

🎨 Une étude révèle l'essor d'artistes-entrepreneurs boostés par l'IA, sans perte de valeur perçue des œuvres générées.

🧠 Une IA permet à un homme paralysé de parler en temps réel en transformant ses ondes cérébrales en voix synthétique presque instantanément.

💬 « Penser, c’est agir dans un espace imaginaire. »

Si ce bulletin vous a apporté quelque chose, forwardez-le à un proche.

Si vous êtes ce proche, devenez lecteur régulier : www.futurproche.ai

Suggestions, retours, collaborations : 💬 [email protected]

Chaque numéro demande du temps et de la rigueur. Votre soutien m’aide à continuer.☕️ M’offrir un café

✒️ Fort de vingt ans dans la création et les médias, Nicolas Huvé Kousmichoff explore chaque semaine pour vous les avancées de l’IA, leurs usages concrets, et les questions qu’elles ouvrent sur notre avenir commun, convaincu que nous vivons un basculement aussi fragile que vertigineux. 🔗linkedin

La transition cognitive est en marche

Chaque semaine, recevez l’essentiel pour suivre ce qui nous arrive.